בתחילת פברואר 2026 גוגל עדכנה את התיעוד הרשמי שלה והבהירה נקודה חשובה שעוררה סערה בעולם ה-SEO:

כשמדובר בסריקת קבצי HTML לטובת תוצאות החיפוש, Googlebot קורא רק את 2MB הראשונים של הקובץ ולא 15MB כפי שהתיעוד הקודם הציג.

ברחבי התעשייה עלו כותרות מבהילות על “קיצוץ דרסטי”, אבל כמו שקורה לא פעם בעולם קידום אתרים, המציאות הרבה יותר מורכבת ופחות מפחידה ממה שהכותרות מרמזות.

במאמר הזה נסביר בדיוק מה השתנה, למה רוב בעלי האתרים יכולים להירגע, מי כן צריך לשים לב, ואיך בודקים אם האתר שלכם חשוף לבעיה.

חשוב לנו במולטינט להביא את המידע כמו שהוא, בלי פאניקה מיותרת אבל גם בלי זלזול בפרטים הטכניים שיכולים להשפיע על ביצועי האתר שלכם בגוגל.

מה בדיוק שינתה גוגל בתיעוד הסריקה

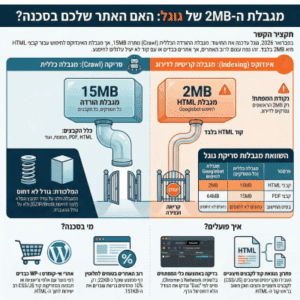

עד ל-5 בפברואר 2026, התיעוד הרשמי של גוגל ציין ש-Googlebot מוריד את 15MB הראשונים של כל קובץ.

העדכון הבהיר שבפועל קיימות שתי מגבלות נפרדות שמתייחסות לשני תהליכים שונים, ויש הבדל מהותי ביניהן.

המגבלה הכללית של 15MB חלה על תשתית הסריקה הרחבה של גוגל, כלומר כל הסורקים והמערכות השונות כמו Google Shopping, Google News, AdSense ואפילו Gemini.

זו מגבלת ההורדה הבסיסית שקיימת מזה שנים. לצד מגבלה זו, קיימת מגבלה ספציפית של 2MB שמתייחסת אך ורק לאופן שבו Googlebot מעבד קבצי HTML לצורך אינדוקס בתוצאות החיפוש.

בנוסף, קבצי PDF זוכים למגבלה גדולה יותר של 64MB.

ג’ון מולר מגוגל הבהיר את הנקודה הזו ברשת החברתית Bluesky כשאמר שגוגל מפעילה סורקים רבים, ולכן ביצעה את ההפרדה בתיעוד.

לדבריו, מדובר במצב נדיר ביותר שבו אתרים נתקלים בבעיה עקב המגבלה, וכי 2MB של HTML זה נפח גדול מאוד.

ההבדל בין סריקה לאינדוקס: למה זה חשוב

כאן הנקודה שרוב הכותרות פספסו.

יש הבדל מהותי בין שני תהליכים שגוגל מבצעת עם כל דף באתר שלכם. התהליך הראשון הוא סריקה (Crawling), כלומר ההורדה של הקובץ מהשרת שלכם.

כאן מגבלת 15MB עדיין תקפה. גוגל יכולה להוריד עד 15MB מכל קובץ. התהליך השני הוא אינדוקס (Indexing), כלומר הניתוח והאחסון של התוכן לצורך דירוג בתוצאות החיפוש. כאן חלה מגבלת 2MB לקבצי HTML.

חשבו על זה כך:

גוגל יכולה להוריד את כל הקובץ שלכם עד 15MB, אבל כשהיא מגיעה לשלב שבו היא מנתחת את התוכן ומחליטה איך לדרג אותו, היא מתייחסת רק ל-2MB הראשונים של קוד ה-HTML.

כל מה שמופיע אחרי הנקודה הזו פשוט לא ייקרא לצורכי דירוג.

חשוב להדגיש שמשאבים חיצוניים כמו קבצי CSS, JavaScript ותמונות שמקושרים דרך URL נטענים בנפרד, ולכל אחד מהם יש מכסת גודל עצמאית. רק תוכן שמוטמע ישירות בתוך קובץ ה-HTML נספר במסגרת מגבלת 2MB.

עד כמה 2MB זה באמת הרבה

בואו נשים את המספרים בפרופורציה. לפי נתוני Web Almanac, דף הבית הממוצע במובייל שוקל כ-22KB של HTML בלבד. זה 0.022MB. כדי להגיע למגבלת 2MB צריך דף שגדול פי 90 מהממוצע.

במונחים מעשיים יותר, 2MB של טקסט זה כ-2 מיליון תווים, מה שמקביל לרומן של כ-400 עמודים.

שאלו את עצמכם שאלה פשוטה: האם דף הבית של האתר שלכם מכיל טקסט בהיקף של רומן שלם? ברוב המוחלט של המקרים התשובה היא לא, וגם לא קרוב לזה.

מי כן צריך לדאוג

למרות שרוב האתרים לא מתקרבים למגבלה, יש מספר סוגי אתרים שכדאי להם לבדוק את עצמם.

קודם כל, אתרי מסחר אלקטרוני עם דפי מוצרים ענקיים שמטעינים אלפי וריאציות של מוצרים לתוך דף אחד, כולל בלוקים גדולים של JSON-LD Structured Data שמוטמעים ישירות ב-HTML.

מדובר למשל בחנויות אונליין שמציגות מאות צבעים, מידות ומחירים בדף מוצר יחיד.

בנוסף, אתרים שמבוססים על אפליקציות Single Page (SPA) שמטמיעים כמויות גדולות של JavaScript ו-CSS ישירות בתוך ה-HTML במקום לקשר לקבצים חיצוניים, עלולים להתקרב למגבלה.

גם אתרי WordPress עם תבניות כבדות ובונים ויזואליים כמו Elementor או Gutenberg שמזריקים CSS Inline בכמויות גדולות, וכן אתרים שמשתמשים ב-Data URLs, כלומר תמונות שמקודדות ב-Base64 ומוטמעות ישירות בקוד ה-HTML במקום להיות מקושרות כקבצים חיצוניים.

מלכודת ה-GZIP: הטעות שחייבים להכיר

יש נקודה טכנית חשובה שהרבה בעלי אתרים לא מודעים אליה.

רוב השרתים משתמשים בדחיסת GZIP או Brotli כדי לשלוח את הקבצים בצורה קומפקטית יותר.

קובץ HTML של 3MB עשוי להידחס ל-150KB בלבד בזמן ההעברה, וזה מה שכלי בדיקה רבים כמו Google PageSpeed Insights מציגים.

אבל המגבלה של 2MB חלה על הנתונים הלא דחוסים, כלומר על הגודל המלא של הקובץ לפני הדחיסה.

תחשבו על זה כמו מזרון שמגיע בקופסה קטנה ודחוסה. גודל הקופסה בזמן המשלוח הוא לא הגודל האמיתי של המזרון, ומבחינת גוגל, מה שקובע הוא הגודל של המזרון אחרי שהוא נפרש.

אם אתם בודקים את גודל הדף שלכם ורואים מספר קטן בכלי הבדיקה, ודאו שאתם מסתכלים על הגודל הלא דחוס ולא על גודל ההעברה.

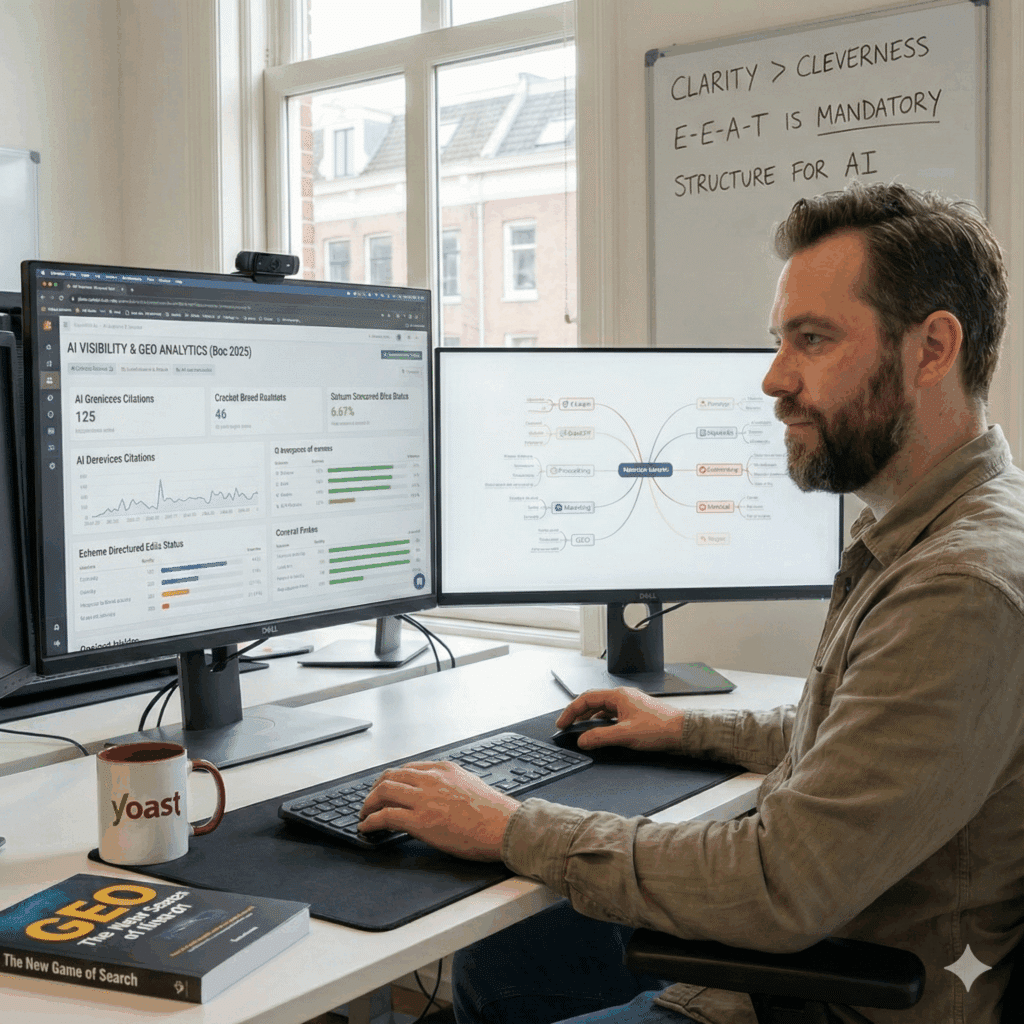

איך בודקים את גודל ה-HTML של האתר שלכם

יש כמה דרכים פשוטות לבדוק אם האתר שלכם נמצא באזור הבטוח. הדרך הראשונה היא באמצעות כלי הפיתוח של Chrome.

לחצו קליק ימני על הדף ובחרו “בדיקה” (Inspect), עברו ללשונית Network, רעננו את הדף ומיינו לפי “Doc” כדי לראות את קובץ ה-HTML הראשי. חשוב לבדוק את הגודל הלא דחוס ולא את גודל ההעברה.

דרך נוספת היא באמצעות כלים כמו Screaming Frog שמאפשר לסרוק את כל האתר ולהציג את גודל ה-HTML של כל דף. אם אתם רואים דפים שמתקרבים ל-1MB כדאי להתחיל לבדוק, ואם הם עוברים את 1.5MB אתם נמצאים באזור הסכנה ומומלץ לטפל בזה.

אפשר גם ללחוץ קליק ימני על כל דף באתר, לבחור “הצג מקור דף” (View Page Source) ולבדוק את גודל הקובץ שמוצג. זו בדיקה מהירה שלא דורשת ידע טכני מתקדם ונותנת תמונה ראשונית טובה.

מה עושים אם האתר קרוב למגבלה

אם הבדיקה העלתה שדפים מסוימים באתר שלכם מתקרבים למגבלת 2MB, יש כמה פעולות מעשיות שאפשר לבצע.

הצעד הראשון והחשוב ביותר הוא להעביר סקריפטים וסטיילים מתוך ה-HTML לקבצים חיצוניים. אם המפתח שלכם הדביק אלפי שורות של JavaScript או CSS ישירות בתוך קוד הדף, כל זה נספר כחלק ממגבלת 2MB.

העברת הקוד לקבצים חיצוניים מוציאה אותו מהחישוב.

בנוסף, כדאי לוודא שהתוכן החשוב ביותר נמצא גבוה ככל האפשר במבנה ה-HTML. גם אם הדף שלכם קרוב למגבלה, אם התוכן העיקרי, הלינקים הפנימיים ונתוני ה-Schema מופיעים בחלק העליון של הקוד, גוגל תצליח לקרוא אותם. מעבר לכך, כדאי לבדוק אם יש תמונות שמקודדות ב-Base64 ומוטמעות ישירות ב-HTML. החלפת Data URLs בתמונות חיצוניות מפחיתה משמעותית את גודל הקובץ.

לבעלי אתרי WordPress, מומלץ לבדוק את כמות ה-CSS Inline שהתבנית או הבונה הוויזואלי מזריקים לכל דף. תבניות מסוימות מגדירות מאות משתני עיצוב בכותרת הדף גם אם הדף הספציפי לא משתמש בהם כלל. מיניפיקציה של הקוד וניקוי סטיילים שלא בשימוש יכולים לחסוך מאות קילובייטים.

ההיבט הרחב יותר: למה גוגל ארגנה מחדש את התיעוד

מעבר לעדכון הטכני עצמו, יש כאן סיפור רחב יותר שכדאי לשים לב אליו. גוגל מארגנת מחדש את כל התיעוד של תשתית הסריקה שלה, ומפרידה בין תיעוד כללי שמתייחס לכל הסורקים לבין תיעוד ספציפי למוצרים שונים כמו חיפוש, חדשות ו-Gemini. המהלך הזה החל בסוף 2025 כשגוגל העבירה את תיעוד הסריקה הבסיסי לאתר נפרד.

הסיבה לכך היא שתשתית הסריקה של גוגל משרתת הרבה יותר מוצרים מעבר לחיפוש הרגיל. ככל שמוצרי AI כמו Gemini מתרחבים ומסתמכים על אותה תשתית סריקה, האופטימיזציה של האתר שלכם כבר לא נוגעת רק לתוצאות החיפוש המסורתיות אלא לנראות שלכם בכל מערכת האקולוגיה של גוגל.

מי שעוסק בקידום בבינה מלאכותית מבין שזו לא רק שאלה של SEO קלאסי אלא של נראות כוללת במגוון מנועי תשובה ומערכות AI.

טבלת השוואה: מגבלות הסריקה של גוגל

| פרמטר | מגבלה כללית (כל הסורקים) | מגבלת Googlebot לחיפוש |

|---|---|---|

| קבצי HTML | 15MB | 2MB |

| קבצי PDF | 15MB | 64MB |

| סוגי קבצים נתמכים אחרים | 15MB | 2MB |

| משאבים חיצוניים (CSS, JS) | נטענים בנפרד | נטענים בנפרד, כל אחד עד 2MB |

| בסיס החישוב | נתונים לא דחוסים | נתונים לא דחוסים |

רגע לפני סיום, מה חשוב לזכור

העדכון של גוגל למגבלות הסריקה הוא בעיקר הבהרת תיעוד ולא שינוי דרמטי בהתנהגות. המגבלה של 2MB לקבצי HTML בחיפוש גוגל ככל הנראה הייתה קיימת מזה שנים, וגוגל פשוט תיעדה אותה בצורה מדויקת יותר. עבור הרוב המוחלט של אתרי האינטרנט, שבהם קובץ ה-HTML שוקל עשרות קילובייטים בלבד, אין כל סיבה לדאגה.

עם זאת, העדכון מהווה תזכורת מצוינת לעקרונות שהיו נכונים תמיד: שמרו על קוד נקי, ודאו שהתוכן החשוב נמצא גבוה ב-HTML, העבירו סקריפטים וסטיילים לקבצים חיצוניים, והימנעו מניפוח מיותר. אלה לא רק עקרונות של קידום אורגני טוב, אלה עקרונות של אתר בריא שמשרת גם את המשתמשים וגם את מנועי החיפוש ומערכות ה-AI כאחד.

רוצים לוודא שהאתר שלכם עומד בכל הדרישות הטכניות של גוגל? צרו קשר עם מולטינט לביקורת טכנית מקיפה של האתר שלכם והתאמתו לדרישות העדכניות ביותר.